最大期望算法

历史

最大期望值算法由Arthur Dempster,Nan Laird和Donald Rubin在他们1977年发表的经典论文中提出。他们指出此方法之前其实已经被很多作者"在他们特定的研究领域中多次提出过"。

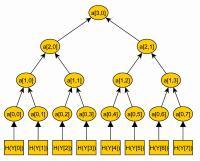

EM简单教程

EM是一个在已知部分相关变量的情况下,估计未知变量的迭代技术。EM的算法流程如下:

初始化分布参数

重复直到收敛:

最大期望过程说明

我们用y{\displaystyle {\textbf {y}}}表示能够观察到的不完整的变量值,用x{\displaystyle {\textbf {x}}}表示无法观察到的变量值,这样x{\displaystyle {\textbf {x}}}和y{\displaystyle {\textbf {y}}}一起组成了完整的数据。x{\displaystyle {\textbf {x}}}可能是实际测量丢失的数据,也可能是能够简化问题的隐藏变量,如果它的值能够知道的话。例如,在混合模型(Mixture Model)中,如果“产生”样本的混合元素成分已知的话最大似然公式将变得更加便利(参见下面的例子)。

估计无法观测的数据

让p{\displaystyle p\,}代表矢量θ θ -->{\displaystyle \theta }: p(y,x|θ θ -->){\displaystyle p(\mathbf {y} ,\mathbf {x} |\theta )}定义的参数概率分布据的概率分布(连续情况下)或者概率聚类函数(离散情况下),那么从这个函数就可以得到全部数据的最大似然值,另外,在给定的观察到的数据条件下未知数据的条件分布可以表示为:

参见

估计理论

数据聚类

参考文献

Arthur Dempster, Nan Laird, and Donald Rubin. "Maximum likelihood from incomplete data via the EM algorithm". Journal of the Royal Statistical Society, Series B, 39 (1):1–38, 1977[1].

Robert Hogg, Joseph McKean and Allen Craig. Introduction to Mathematical Statistics. pp. 359-364. Upper Saddle River, NJ: Pearson Prentice Hall, 2005.

Radford Neal, Geoffrey Hinton. "A view of the EM algorithm that justifies incremental, sparse, and other variants". In Michael I. Jordan (editor), Learning in Graphical Models pp 355-368. Cambridge, MA: MIT Press, 1999.

The on-line textbook: Information Theory, Inference, and Learning Algorithms,by David J.C. MacKay includes simple examples of the E-M algorithm such as clustering using the soft K-means algorithm, and emphasizes the variational view of the E-M algorithm.

A Gentle Tutorial of the EM Algorithm and its Application to Parameter Estimation for Gaussian Mixture and Hidden Markov Models,by J. Bilmes includes a simplified derivation of the EM equations for Gaussian Mixtures and Gaussian Mixture Hidden Markov Models.

Information Geometry of the EM and em Algorithms for Neural Networks,by Shun-Ichi Amari give a view of EM algorithm from geometry view point.

免责声明:以上内容版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。感谢每一位辛勤著写的作者,感谢每一位的分享。

- 有价值

- 一般般

- 没价值

24小时热门

推荐阅读

知识互答

关于我们

APP下载

{{item.time}} {{item.replyListShow ? '收起' : '展开'}}评论 {{curReplyId == item.id ? '取消回复' : '回复'}}